La numérisation du monde

News Mediarail.be

Hier

On fait souvent référence à l'avenir en se reposant sur le seul secteur numérique. Si cela peut sembler exagéré, il ne faut pas non plus sous-estimer l'ampleur de la transformation. On peut accéder directement aux parties de cette page :

> La courbe du progrès : la loi de Moore

> Un bref historique de la digitalisation

> 2007, l’année qui changea le monde

> Technologies numériques

> Que pourront faire nos ordinateurs et nos technologies numériques ?

> Les conséquences sur l’emploi

> L’environnement social bouleversé

> Les puces, l'identification biométrique, les capteurs, où en est-on ?

Une courbe ascendante depuis plus de 250 ans

Aujourd'hui, plus personne n'est à l'abri de l'informatique pour la bonne raison que le monde numérique qu'elle a créé se superpose dorénavant au monde réel. Progressivement, le numérique tricote un nouveau tissu. Il ne s'agit pas ici de l’émergence d’une nouvelle énergie mais du potentiel d’un nouveau phénomène technologique : la numérisation. Une numérisation qui permet l’édification d’un nouveau monde, virtuel, à partir duquel il est possible de piloter le monde physique tel que nous le connaissons. Au cours des deux siècles qui se sont écoulés, James Watt a amorcé malgré lui la transition vers la production de masse, puis ce fût suivi de deux autres révolutions : à la fin du 19e siècle, grâce à l'électrification et à la division du travail, puis à la fin du 20e siècle, grâce aux technologies de l'information. La numérisation constitue la prochaine avancée technologique majeure qui va révolutionner le monde. Des robots intelligents et des drones, des imprimantes 3D ou encore des véhicules sans chauffeur. La quatrième révolution industrielle est là.

Il y a encore - et il y aura toujours - les tenants de l'optimisme techno et les déclinistes revendiqués. Mais il suffit de comparer la différence des microprocesseurs (près de 30 ans), avec le laps de temps qui sépare 1997 à 2007, pour comprendre l'amplitude du changement. En 1997, la micro informatique est encore largement exploitée par le biais du quatuor "tour-écran-clavier-souris". Il faut un câble relié à sa propre téléphonie pour recevoir - et envoyer - des données. En 2007, cet ensemble se réduit à un écran 7x13cm appelé smartphone et communique par la technologie 3G autorisant une transmission massive et rapide de voix et données.

Les datas seront probablement le prochain "or noir numérique" de l'industrie. Quiconque amassera les données aura un accès illimité à la vie de tout un chacun. Ce qui peut permettre d'offrir des services et produits non plus standardisés, mais conçus sur mesure et en temps réel. Et cela, pour le chemin de fer, c'est une question de vie ou de mort...

> La courbe du progrès : la loi de Moore

> Un bref historique de la digitalisation

> 2007, l’année qui changea le monde

> Technologies numériques

> Que pourront faire nos ordinateurs et nos technologies numériques ?

> Les conséquences sur l’emploi

> L’environnement social bouleversé

> Les puces, l'identification biométrique, les capteurs, où en est-on ?

Une courbe ascendante depuis plus de 250 ans

Aujourd'hui, plus personne n'est à l'abri de l'informatique pour la bonne raison que le monde numérique qu'elle a créé se superpose dorénavant au monde réel. Progressivement, le numérique tricote un nouveau tissu. Il ne s'agit pas ici de l’émergence d’une nouvelle énergie mais du potentiel d’un nouveau phénomène technologique : la numérisation. Une numérisation qui permet l’édification d’un nouveau monde, virtuel, à partir duquel il est possible de piloter le monde physique tel que nous le connaissons. Au cours des deux siècles qui se sont écoulés, James Watt a amorcé malgré lui la transition vers la production de masse, puis ce fût suivi de deux autres révolutions : à la fin du 19e siècle, grâce à l'électrification et à la division du travail, puis à la fin du 20e siècle, grâce aux technologies de l'information. La numérisation constitue la prochaine avancée technologique majeure qui va révolutionner le monde. Des robots intelligents et des drones, des imprimantes 3D ou encore des véhicules sans chauffeur. La quatrième révolution industrielle est là.

Il y a encore - et il y aura toujours - les tenants de l'optimisme techno et les déclinistes revendiqués. Mais il suffit de comparer la différence des microprocesseurs (près de 30 ans), avec le laps de temps qui sépare 1997 à 2007, pour comprendre l'amplitude du changement. En 1997, la micro informatique est encore largement exploitée par le biais du quatuor "tour-écran-clavier-souris". Il faut un câble relié à sa propre téléphonie pour recevoir - et envoyer - des données. En 2007, cet ensemble se réduit à un écran 7x13cm appelé smartphone et communique par la technologie 3G autorisant une transmission massive et rapide de voix et données.

Les datas seront probablement le prochain "or noir numérique" de l'industrie. Quiconque amassera les données aura un accès illimité à la vie de tout un chacun. Ce qui peut permettre d'offrir des services et produits non plus standardisés, mais conçus sur mesure et en temps réel. Et cela, pour le chemin de fer, c'est une question de vie ou de mort...

Aujourd'hui

xx

Demain

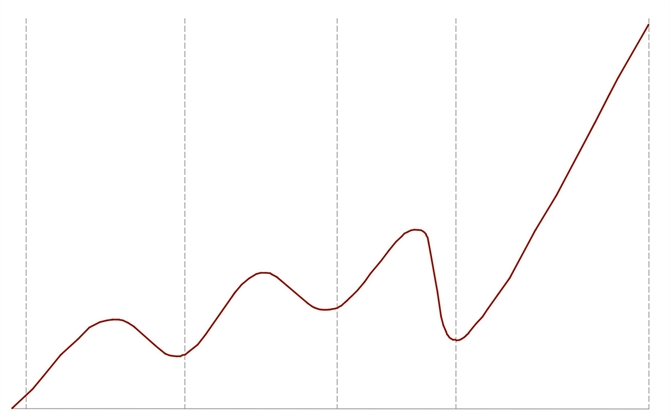

Deux périodes, trois cycles et quatre révolutions industrielles

L'histoire économique de deux derniers siècles du précédent millénaire peut se résumer par le graphique ci-dessous, en distinguant deux périodes essentielles : celle de l'industrie et celle des voix et données. Les trois cycles de Kondratiev (1892-1931) montrent à chaque fois une phase d'ascension suivi d'une phase de déclin puis à nouveau une reprise ascendante. Ces cycles ne correspondent qu'aux deux premières révolutions industrielles. La troisième révolution, celle des technologies de l'information, entame ce qui devrait être un quatrième cycle. Mais on voit que la courbe est ascendante depuis près de 70 ans et que rien ne permet à ce jour de prévoir une phase de déclin. Le sommet de la courbe ascendante correspond à nos jours et situe le début de la quatrième révolution industrielle qui nous occupe à cette page.

Période industrielle

Période voix & données

Application de l'électricité tant dans l'industrie que pour le grand public.

Économie du pétrole

Aviation / autos

Aviation / autos

Application de la technologie à vapeur en transport et industrie

1820: 1er train tiré par une locomotive

1820: 1er train tiré par une locomotive

4ème révolution

industrielle

industrielle

4e ??

Fin de l'énergie à vapeur

3e

2e

1er

3ème révolution

industrielle

industrielle

2ème révolution

industrielle

industrielle

1ère révolution industrielle

1780

1842

1897

1945

2007

La courbe du progrès : la loi de Moore

Généralement, l’usage présente le progrès à l’aide une courbe dessinée sur deux axes X-Y – en abscisse et ordonnée - débutant très plat à gauche, puis au fur et à mesure des siècles et des décennies, la courbe se cabre, prend de la hauteur puis devient presque verticale. Plusieurs équipes de scientifiques expliquent cette courbe à leur manière. Si le plus ancien dessin sur la paroi d'une caverne remonte à environ 30 000 ans, ce n’est depuis un peu plus de 500 ans que l'imprimerie accélérait prodigieusement la diffusion du savoir. A cette époque, il fallait à peu près un siècle pour que le monde en soit transformé. La courbe jusque-là est donc effectivement très plate. En 1769, Thomas Newcomen fait breveter la chambre de condensation séparée pour la machine à vapeur, transfigurant de manière durable l’extraction du charbon et plaçant l’Angleterre comme première puissance mondiale. Cinquante plus tard, la même machine, un peu plus perfectionnée, prenait place sur des roues guidées par deux rails, créant un mobile révolutionnaire nommé train et engendrant un boom exponentiel des exportations industrielles – et pas seulement que du charbon - puis, par après, simplifia en moins de quarante ans le déplacement des personnes, confinées jusque-là à la marche à pied et au cheval, pour les plus nantis. Dès 1880, l’électricité entra petit à petit dans tous les foyers, puis, s’en suivra le téléphone, le télégraphe, la machine à écrire… S’en suivit plus tard le telex, le Minitel français, le traitement de texte puis le PC. Un espace de moins de dix ans sépare l’Internet à faible débit monopolisant votre ligne téléphonique durant des heures, de la 4G actuelle permettant la connexion sans fil en tout lieu et à tout moment…

Cette représentation exponentielle du progrès peut aussi s’expliquer par une légende paraît-il bien connue. Un roi devait récompenser l’inventeur du jeu d’échec. Ce dernier ne désirant que du riz, le roi lui demande quelle quantité il souhaite. L’inventeur pose alors un grain de riz sur la première case de l’échiquier, puis deux sur la deuxième, quatre sur la troisième, huit sur la quatrième et propose au roi de poursuivre lui-même le jeu. Le souverain ne se rendra pas compte que de multiplier par deux chaque quantité de grains à chaque case abouti à la dernière case à un chiffre monstrueux : 18 milliards de milliards de grains de riz.

Les nombreux experts en industrie digitale font aussi référence à la Loi de Moore, du nom du cofondateur d’Intel, et qui fixait que le nombre de transistors des microprocesseurs sur une puce de silicium doublerait tous les deux ans, décuplant le rendement des machines et rendant chaque nouveau modèle d’ordinateur rapidement obsolète. Gordon Moore en déduisit que la puissance des ordinateurs allait croître de manière exponentielle, et ce pour des années, comme le fût la courbe du progrès mentionnée plus haut. Sa loi, fondée sur un constat empirique, a été vérifiée jusqu'à aujourd'hui. Selon les observateurs du monde digital, la Loi de Moore aurait à présent dépassé la seconde moitié de l’échiquier, celle des plus grands nombres. Conscient du phénomène, Moore a cependant déclaré en 1997 que cette croissance des performances des puces se heurterait [probablement] à une limite physique : celle de la taille des atomes. Et nous verrons plus loin qu’on y est proche… Si les progrès de la miniaturisation fixent le rythme d'évolution de la technologie du matériel, c'est surtout la vitesse de déploiement du logiciel qui est déterminante pour la digitalisation de toutes les activités industrielles et intellectuelles. Or on remarque que cette courbe n’a pas fléchit…

Cette représentation exponentielle du progrès peut aussi s’expliquer par une légende paraît-il bien connue. Un roi devait récompenser l’inventeur du jeu d’échec. Ce dernier ne désirant que du riz, le roi lui demande quelle quantité il souhaite. L’inventeur pose alors un grain de riz sur la première case de l’échiquier, puis deux sur la deuxième, quatre sur la troisième, huit sur la quatrième et propose au roi de poursuivre lui-même le jeu. Le souverain ne se rendra pas compte que de multiplier par deux chaque quantité de grains à chaque case abouti à la dernière case à un chiffre monstrueux : 18 milliards de milliards de grains de riz.

Les nombreux experts en industrie digitale font aussi référence à la Loi de Moore, du nom du cofondateur d’Intel, et qui fixait que le nombre de transistors des microprocesseurs sur une puce de silicium doublerait tous les deux ans, décuplant le rendement des machines et rendant chaque nouveau modèle d’ordinateur rapidement obsolète. Gordon Moore en déduisit que la puissance des ordinateurs allait croître de manière exponentielle, et ce pour des années, comme le fût la courbe du progrès mentionnée plus haut. Sa loi, fondée sur un constat empirique, a été vérifiée jusqu'à aujourd'hui. Selon les observateurs du monde digital, la Loi de Moore aurait à présent dépassé la seconde moitié de l’échiquier, celle des plus grands nombres. Conscient du phénomène, Moore a cependant déclaré en 1997 que cette croissance des performances des puces se heurterait [probablement] à une limite physique : celle de la taille des atomes. Et nous verrons plus loin qu’on y est proche… Si les progrès de la miniaturisation fixent le rythme d'évolution de la technologie du matériel, c'est surtout la vitesse de déploiement du logiciel qui est déterminante pour la digitalisation de toutes les activités industrielles et intellectuelles. Or on remarque que cette courbe n’a pas fléchit…

xx

Un bref historique de la digitalisation

En 1945, John von Neumann introduisit une écriture uniformisée pour écrire des instructions pour le traitement des données et les données elles-mêmes. Instructions et données étaient ainsi manipulées de la même manière par une machine, ouvrant la voie à l'ordinateur moderne. Le transistor a été inventé lui, en 1948 par John Bardeen, William Schockley et Walter Brattain, trois chercheurs des laboratoires américains Bell. Les premières cartes perforées apparaissent vers 1950. Le concept de microprocesseur date quant à lui de 1969. Mais il faut attendre 1974 pour qu’Intel commercialise son modèle 8080 qui équipe les tous premiers PC tels l'Altair 8800 de MITS et l'Imsai 8080. La synergie entre ces composants, de moins en moins chers et de plus en plus miniaturisés, et l’idée géniale de Steve Jobs puis de Microsoft d’en faire une application accessible à tous, a provoqué une croissance explosive de l’informatique que nous connaissons actuellement.

On peut se résumer l’impact du digital sur notre monde en trois étapes :

1 – L’ère des mainframes (1970-1990) : il s’agit de grands ordinateurs centraux utilisés pour accomplir un très petit nombre de tâches répétitives, comme les fiches de paie d'une entreprise ou d’autres tâches administratives.

2 - L'ère de la micro-informatique (1990-2020), où les ordinateurs deviennent accessibles à tous, et offre à l’utilisateur une interface graphique pour gérer différentes tâches. Cette ère rend l’informatique conviviale et nécessite des personnels de moins en moins spécialisés.

3 - L'ère de l'intelligence artificielle, qui est désormais à nos portes. Celle-ci permet de résoudre des tâches complexes dotées d’un haut degré d'incertitude : traduire la question d’un humain, évaluer la probabilité de réponses correctes, parmi le choix de plusieurs millions, en une milliseconde, et fournir la réponse adéquate sous une forme compréhensible.

On peut se résumer l’impact du digital sur notre monde en trois étapes :

1 – L’ère des mainframes (1970-1990) : il s’agit de grands ordinateurs centraux utilisés pour accomplir un très petit nombre de tâches répétitives, comme les fiches de paie d'une entreprise ou d’autres tâches administratives.

2 - L'ère de la micro-informatique (1990-2020), où les ordinateurs deviennent accessibles à tous, et offre à l’utilisateur une interface graphique pour gérer différentes tâches. Cette ère rend l’informatique conviviale et nécessite des personnels de moins en moins spécialisés.

3 - L'ère de l'intelligence artificielle, qui est désormais à nos portes. Celle-ci permet de résoudre des tâches complexes dotées d’un haut degré d'incertitude : traduire la question d’un humain, évaluer la probabilité de réponses correctes, parmi le choix de plusieurs millions, en une milliseconde, et fournir la réponse adéquate sous une forme compréhensible.

Tout le monde peut tout faire

Les années 2000 voient l'arrivée de ce qu'on appelle l'open source, soit des « code source ouvert » qui s'appliquent aux logiciels dont la licence respecte des critères précisément établis par l'Open Source Initiative, c'est-à-dire les possibilités de libre redistribution, d'accès au code source et de création de travaux. Cette nouveauté a bouleversé le business classique des grandes firmes, comme IBM ainsi que celui des éditeurs de logiciels. Les réseaux sociaux ont pour leur part bousculé le business des médias, notamment en faisant voler en éclat l'accès et le filtrage de l'info.

Les années 2000 voient l'arrivée de ce qu'on appelle l'open source, soit des « code source ouvert » qui s'appliquent aux logiciels dont la licence respecte des critères précisément établis par l'Open Source Initiative, c'est-à-dire les possibilités de libre redistribution, d'accès au code source et de création de travaux. Cette nouveauté a bouleversé le business classique des grandes firmes, comme IBM ainsi que celui des éditeurs de logiciels. Les réseaux sociaux ont pour leur part bousculé le business des médias, notamment en faisant voler en éclat l'accès et le filtrage de l'info.

xx

2007, l’année qui changea le monde

L’année 2007 est comme le grand vin : un cru exceptionnel qui fût celui où l’informatique fît un grand bon. Qu’y-a-t-il eu de si particulier ? Cette année-là, un faisceau d’entreprises et d’innovations émergentes a transformé la manière dont les individus et les machines communiquaient, créaient, collaboraient et pensaient. Il y eut d’abord Steve Jobs qui dévoila un petit objet révolutionnaire qu’on mettait dans sa poche : l’iPhone. Un peu auparavant, à l’automne 2006, le réseau social réservés aux lycéens, Facebook, s’ouvrait à tous les individus du monde entier, âgés de plus de treize ans et munis d’une adresse e-mail. En 2007 toujours, une plateforme de microblogging du nom de Twitter s’internationalisait, tandis que Google lançait son système d’exploitation Androïd, popularisant les smartphones autres que l’iPhone précité et son système iOS. Dans un appartement de San Fransisco, naissait Airbnb alors qu’Amazon commercialisait le Kindle. Et c’est toujours en 2007 qu’une équipe d’IBM débutait le développement d’un ordinateur cognitif du nom de Watson, celui-là même qui participa en février 2011 à trois manches du jeu télévisé Jeopardy!, au terme desquelles il a remporté le jeu. Enfin Intel réinventa le composant de base de l’ère numérique, ouvrant la voie à une nouvelle génération de processeurs plus rapides et moins gourmants en énergie. Oui, manifestement, 2007 fût un grand cru exceptionnel…

xx

Technologies numériques

Les appareils électroniques sont composés de cinq éléments essentiels :

- les circuits imprimés qui font les calculs ;

- les mémoires qui stockent les données ;

- les réseaux qui les font circuler dans l’appareil ;

- les logiciels qui leur font exécuter un grand nombre de tâches ;

- les capteurs qui détectent les mouvements, la parole, les sons, la lumière, le rythme cardiaque,…

Le circuit intégré complet apparut pour la première fois dans les années 60, aidés par les programmes spatiaux des États-Unis et les recherches de la Défense sur le missile Minuteman. Les premières puces accueillent 30 composants sur une surface de quelques mm². En 1965, le circuit le plus performant comportait 64 transistors. En 1974, le microprocesseur Intel 8080 en possédait déjà 5 000 et en 1980, on installait allègrement pas moins de 100.000 composants, chiffre qui atteint le milliard de transistors vers 2010, sur une puce de la taille d’un ongle ! Entre la première génération de puces et la dernière (2016), la puissance des microprocesseurs a été multipliée par 3500, leur consommation d’énergie divisée par 90.000 et leur coût de production par 60.000. La Loi de Moore et la légende de l’échiquier ne se sont donc pas démenties, loin s’en faut. Comme ces chiffres ne parlent pas, on les compare volontiers à un objet culte : l’auto. Si celle-ci devait subir le même rythme de croissance que les puces, nous aurions un véhicule qui roulerait à 180.000 km/h, consommerait un litre sur 800.000 km et coûterait 3 à 6 centimes en production. Mais comment l’informatique en est-elle arrivée là ?

Depuis les années 70, l’industrie a réussi à réduire la taille des transistors à coût constant, multipliant ainsi le nombre d’interrupteurs pour le même prix. Les premiers microprocesseurs comportaient une couche de fil d’aluminium. Les puces actuelles en comporte treize fabriquées à l’échelle nanoscopique. L’échelle d’intégration, soit la largeur des pistes de silicium que l’on peut réaliser, a fondu pour atteindre les 22 nanomètres en 2011. On en est actuellement à 14 nanomètres et la technologie se dirige vers les 10 nanomètres. On estime que les limites physiques seraient atteintes à 5 nanomètres. On n’en est a étudier d’autres technologies, comme des nanotubes de carbone dont la taille ne serait que de quelques dizaine d’atomes, soit 500 fois plus petits que les transistors actuels. Cette réduction de taille permet une augmentation fascinante des quantités de traitement des données et de leur transmission.

Mais une autre technologie a fait elle aussi un grand bon : la téléphonie mobile. A l’origine, elle est conçue pour les simples conversations et quelques texto : c'est la 1G (première génération) qui travaille par fréquences radios FM. Puis vînt le standard européen du réseau cellulaire GSM (Groupe spécial mobile) qui avait pour protocole le TDMA, norme appliquée dès 1987. Cette technologie faisait que chaque appel monopolisait un canal spécifique, et les américains ressortirent du coup un projet de normes CDMA qui permettaient d’étaler le spectre des fréquences, de « hacher » un appel et de le reconstituer chez le destinataire : ce fût la 2G, qui se limitait au maximum à quelques SMS. Cependant cette norme CDMA promettait à l’avenir de la transmission de données à haut débit. Ce fût décisif pour son application mondiale. En 1996, elle entrait en phase industrielle à un moment où internet se popularise : c’est la naissance de la 3G autorisant une transmission massive et rapide de voix et données. Avec l’arrivée des smartphones dès 2007, c’est tout l’univers de l’Internet qui doit être accessible sans fil : la 4G l’a permis en assurant une fluidité équivalente à du haut débit filaire. La 5G est en gestation : on ne savait pas encore en 2017 les apports supplémentaires….

En résumé, au cours de ces dernières années, de nombreux composants numériques ont progressivement été plus abordables à tous, leurs performances se sont améliorées et leur taille a diminué. C’est la combinaison de la téléphonie et de ces composants qui a créé le monde d’aujourd’hui. Nous sommes entré dans l’âge de l’accès.

- les circuits imprimés qui font les calculs ;

- les mémoires qui stockent les données ;

- les réseaux qui les font circuler dans l’appareil ;

- les logiciels qui leur font exécuter un grand nombre de tâches ;

- les capteurs qui détectent les mouvements, la parole, les sons, la lumière, le rythme cardiaque,…

Le circuit intégré complet apparut pour la première fois dans les années 60, aidés par les programmes spatiaux des États-Unis et les recherches de la Défense sur le missile Minuteman. Les premières puces accueillent 30 composants sur une surface de quelques mm². En 1965, le circuit le plus performant comportait 64 transistors. En 1974, le microprocesseur Intel 8080 en possédait déjà 5 000 et en 1980, on installait allègrement pas moins de 100.000 composants, chiffre qui atteint le milliard de transistors vers 2010, sur une puce de la taille d’un ongle ! Entre la première génération de puces et la dernière (2016), la puissance des microprocesseurs a été multipliée par 3500, leur consommation d’énergie divisée par 90.000 et leur coût de production par 60.000. La Loi de Moore et la légende de l’échiquier ne se sont donc pas démenties, loin s’en faut. Comme ces chiffres ne parlent pas, on les compare volontiers à un objet culte : l’auto. Si celle-ci devait subir le même rythme de croissance que les puces, nous aurions un véhicule qui roulerait à 180.000 km/h, consommerait un litre sur 800.000 km et coûterait 3 à 6 centimes en production. Mais comment l’informatique en est-elle arrivée là ?

Depuis les années 70, l’industrie a réussi à réduire la taille des transistors à coût constant, multipliant ainsi le nombre d’interrupteurs pour le même prix. Les premiers microprocesseurs comportaient une couche de fil d’aluminium. Les puces actuelles en comporte treize fabriquées à l’échelle nanoscopique. L’échelle d’intégration, soit la largeur des pistes de silicium que l’on peut réaliser, a fondu pour atteindre les 22 nanomètres en 2011. On en est actuellement à 14 nanomètres et la technologie se dirige vers les 10 nanomètres. On estime que les limites physiques seraient atteintes à 5 nanomètres. On n’en est a étudier d’autres technologies, comme des nanotubes de carbone dont la taille ne serait que de quelques dizaine d’atomes, soit 500 fois plus petits que les transistors actuels. Cette réduction de taille permet une augmentation fascinante des quantités de traitement des données et de leur transmission.

Mais une autre technologie a fait elle aussi un grand bon : la téléphonie mobile. A l’origine, elle est conçue pour les simples conversations et quelques texto : c'est la 1G (première génération) qui travaille par fréquences radios FM. Puis vînt le standard européen du réseau cellulaire GSM (Groupe spécial mobile) qui avait pour protocole le TDMA, norme appliquée dès 1987. Cette technologie faisait que chaque appel monopolisait un canal spécifique, et les américains ressortirent du coup un projet de normes CDMA qui permettaient d’étaler le spectre des fréquences, de « hacher » un appel et de le reconstituer chez le destinataire : ce fût la 2G, qui se limitait au maximum à quelques SMS. Cependant cette norme CDMA promettait à l’avenir de la transmission de données à haut débit. Ce fût décisif pour son application mondiale. En 1996, elle entrait en phase industrielle à un moment où internet se popularise : c’est la naissance de la 3G autorisant une transmission massive et rapide de voix et données. Avec l’arrivée des smartphones dès 2007, c’est tout l’univers de l’Internet qui doit être accessible sans fil : la 4G l’a permis en assurant une fluidité équivalente à du haut débit filaire. La 5G est en gestation : on ne savait pas encore en 2017 les apports supplémentaires….

En résumé, au cours de ces dernières années, de nombreux composants numériques ont progressivement été plus abordables à tous, leurs performances se sont améliorées et leur taille a diminué. C’est la combinaison de la téléphonie et de ces composants qui a créé le monde d’aujourd’hui. Nous sommes entré dans l’âge de l’accès.

xx

Que pourront faire nos ordinateurs et nos technologies numériques ?

Des tâches inimaginables il y a quelques années. La combinaison des composants technologiques avec de nouveaux services de téléphonie a rendu le monde totalement interconnectable, de sorte qu’on connait en Europe le prix du ticket de métro de Melbourne ou la localisation du meilleur bar à sushis de Montréal. Le site Flightradar.com montre la position en temps réel de tous les avions du monde, ainsi que le type d’avion, l’horaire prévu et l’horaire réel. La quantité de données nécessaires pour obtenir ces informations est peu connue du grand public. Elle n’est possible que grâce au principe de l’open data qui circule dans un réseau mondial de serveurs.

Mais la nouvelle ère qui s’ouvre va bien au-delà de ce que nous connaissons actuellement. La capacité des intelligences artificielles à traiter des tâches à très haut degré d'incertitude va introduire dans les années qui viennent un choc compétitif dans tous les pans de la société, de l’industrie et des services où les gains de productivité sont historiquement plus faibles pour un tas de raisons. Se renforçant mutuellement, les avancées technologiques mentionnées plus haut permettent d’offrir des machines capables de traiter des quantités incommensurables de données à une vitesse inédite et qui sont en mesure de reconnaître des récurrences et d’apprendre pratiquement aussi vite que nos cerveaux.

Certaines sociétés de trading permettent déjà de donner près de 100.000 ordres d’achat et de vente à la seconde ! Nous entrons dans l’ère du temps réel. Les dizaines de milliers de données qui peuvent transiter dans des fibres optiques permettent de surveiller ou d’ordonner des enclenchements ferroviaires à des dizaines de kilomètres à la ronde, en quelques millisecondes. Les capteurs surveillent la consommation des moteurs d’aiguillages ou l’usure des essieux. Le CEO de General Electric évoque ainsi la possibilité de mesurer la vitesse idéale des trains selon la météo, les moteurs pouvant être poussés à 120% en cas de canicule. Une adaptation de la vitesse de seulement 2 km/h peut représenter près de 250 millions de $ de bénéfices annuels pour une entreprise ferroviaire géante comme Norfolk Southern. Chez Siemens Mobility, on explique qu’un parc de trains peut envoyer jusqu’à 50 millions de rapports de situation par an, et que ces données pourraient être exploitées pour améliorer la fiabilité du parc et réduire les coûts de maintenance. Nous reviendrons à une autre page pour les spécificités ferroviaires.

Généralement, de nouvelles idées utiles accumulent du capital intellectuel dans l'économie, en permettant une croissance de la productivité et en recréant de l'espace pour d’autres innovations. Dans l’industrie digitale, par exemple, les équipements de production classiques sont combinés avec de nouveaux micro-capteurs, des appareils mobiles, des réseaux informatiques et des services cloud. Cela signifie que le téléphone intelligent est une innovation dans laquelle de nombreuses autres innovations plus petites ont été combinées. Chaque composant de téléphone intelligent est le résultat de nombreuses innovations antérieures. Le téléphone intelligent constitue à son tour une partie essentielle de nombreuses innovations futures. Et tout cela n’est encore rien à côté de l’intelligence artificielle (AI).

Huit secteurs sont déjà impactés par l’arrivée de l’AI et promettent d’être largement réinventés dans les années futures, notamment par les progrès de la recherche dans les domaines clés : apprentissage automatique, vision par ordinateur, robotique, traitement automatique du langage, systèmes autonomes collaboratifs, crowdsourcing, théorie des jeux, internet des objets, et électronique neuromorphique (imitation artificielle des réseaux neuro-biologiques). Plus lointaine, l'informatique quantique nous permettra d’obtenir de grandes percées dans la science réalisées par des ordinateurs, lesquels ne seront plus attachés aux simples chiffres binaires 0 et 1.

Mais la nouvelle ère qui s’ouvre va bien au-delà de ce que nous connaissons actuellement. La capacité des intelligences artificielles à traiter des tâches à très haut degré d'incertitude va introduire dans les années qui viennent un choc compétitif dans tous les pans de la société, de l’industrie et des services où les gains de productivité sont historiquement plus faibles pour un tas de raisons. Se renforçant mutuellement, les avancées technologiques mentionnées plus haut permettent d’offrir des machines capables de traiter des quantités incommensurables de données à une vitesse inédite et qui sont en mesure de reconnaître des récurrences et d’apprendre pratiquement aussi vite que nos cerveaux.

Certaines sociétés de trading permettent déjà de donner près de 100.000 ordres d’achat et de vente à la seconde ! Nous entrons dans l’ère du temps réel. Les dizaines de milliers de données qui peuvent transiter dans des fibres optiques permettent de surveiller ou d’ordonner des enclenchements ferroviaires à des dizaines de kilomètres à la ronde, en quelques millisecondes. Les capteurs surveillent la consommation des moteurs d’aiguillages ou l’usure des essieux. Le CEO de General Electric évoque ainsi la possibilité de mesurer la vitesse idéale des trains selon la météo, les moteurs pouvant être poussés à 120% en cas de canicule. Une adaptation de la vitesse de seulement 2 km/h peut représenter près de 250 millions de $ de bénéfices annuels pour une entreprise ferroviaire géante comme Norfolk Southern. Chez Siemens Mobility, on explique qu’un parc de trains peut envoyer jusqu’à 50 millions de rapports de situation par an, et que ces données pourraient être exploitées pour améliorer la fiabilité du parc et réduire les coûts de maintenance. Nous reviendrons à une autre page pour les spécificités ferroviaires.

Généralement, de nouvelles idées utiles accumulent du capital intellectuel dans l'économie, en permettant une croissance de la productivité et en recréant de l'espace pour d’autres innovations. Dans l’industrie digitale, par exemple, les équipements de production classiques sont combinés avec de nouveaux micro-capteurs, des appareils mobiles, des réseaux informatiques et des services cloud. Cela signifie que le téléphone intelligent est une innovation dans laquelle de nombreuses autres innovations plus petites ont été combinées. Chaque composant de téléphone intelligent est le résultat de nombreuses innovations antérieures. Le téléphone intelligent constitue à son tour une partie essentielle de nombreuses innovations futures. Et tout cela n’est encore rien à côté de l’intelligence artificielle (AI).

Huit secteurs sont déjà impactés par l’arrivée de l’AI et promettent d’être largement réinventés dans les années futures, notamment par les progrès de la recherche dans les domaines clés : apprentissage automatique, vision par ordinateur, robotique, traitement automatique du langage, systèmes autonomes collaboratifs, crowdsourcing, théorie des jeux, internet des objets, et électronique neuromorphique (imitation artificielle des réseaux neuro-biologiques). Plus lointaine, l'informatique quantique nous permettra d’obtenir de grandes percées dans la science réalisées par des ordinateurs, lesquels ne seront plus attachés aux simples chiffres binaires 0 et 1.

xx

Les conséquences sur l’emploi

Le thème de l’emploi a trait à la croissance des connaissances des individus et aux types d’emplois susceptibles d’être créés à l’avenir. Au cours de la première révolution industrielle, le capital humain représentait un facteur très secondaire, dans la mesure où les ouvriers travaillant dans les hauts-fourneaux et l’industrie en général n'avaient besoin que d'une formation rudimentaire pour mettre en œuvre ces techniques. Les progrès techniques du XXème siècle, où les technologies se sont largement sophistiquées, ont ensuite exigé de la main d’œuvre de plus en plus qualifiée. Savoir lire, écrire et compter était indispensable pour pouvoir envoyer un télégramme, calculer un bilan comptable, monter un moteur électrique, étudier une navette spatiale ou tout simplement…enseigner des matières de plus en plus difficiles.

Actuellement, la ‘digitalisation’ du monde fait naître les mêmes questions que dans les années 1800 : y-a-t-il destruction de l’emploi ? Y-aura-t-il la fameuse ‘destruction créatrice’ chère à Schumpeter ? Les thèses s’affrontent durement, entre les optimistes et les déclinistes. En 2007, une étude signée par l'économiste Robert Atkinson soulignait qu'« il est improbable que le secteur du numérique crée un nombre proportionnel d'emplois avec sa taille. En partie parce que la productivité de ce secteur est telle qu'elle lui permet de produire beaucoup avec moins de travailleurs. » C’est bien connu : les progrès technologiques permettent d’effectuer plus de tâches par un seul homme qu’auparavant. Les locomotives à vapeur demandaient jadis deux hommes quand les locomotives électriques n’en demandent plus qu’un. Et les métros automatiques peuvent à présent s’en passer !

Mais comme par le passé, les innovations créées engendrent l’apparition d’autres innovations, d’autres emplois. Beaucoup d’innovations sont créées en combinant les idées anciennes avec les nouvelles. Les innovations permettent à leur tour de combiner de nouveaux types d'idées. Certaines des combinaisons réussissent à améliorer la productivité, d'autres pas. Le chômage technologique est une menace théorique depuis longtemps, mais pas mal d’études confirment qu’il ne s'est pas concrétisé au niveau de l'ensemble de l'économie : la quantité de travail n'a pas diminué sur le long terme, mais la nature des tâches exécutées a en revanche changé. En résumé, tout est affaire de compétences.

Le développement technologique crée en effet de nouveaux emplois plus productifs pour ceux qui sont capables d'exploiter de nouvelles machines. Au cours des dernières décennies, le développement technologique a en effet augmenté la demande de main-d'œuvre dans des tâches nécessitant un haut niveau d'éducation ainsi que des tâches complexes et de résolution de problèmes, en plus des tâches manuelles à faible salaire qui ne peuvent pas être transférées aux machines. Il n’est cependant pas dit que cela continuera à l’avenir de cette manière. Une certitude, la structure éducative de la population et l'offre de main-d'œuvre pour des emplois nécessitant un haut niveau d'expertise deviennent des facteurs clés et pourraient, à leur tour, créer davantage d’emplois dans l’enseignement et dans les formations en entreprises. Les entreprises traditionnelles seront dès lors priées d’offrir à leurs employés des formations continues, leur fournissant ainsi un capital humain supérieur à leurs concurrents.

Dans un autre registre, la baisse des prix des composants et l’addition de services sans cesse nouveaux permettent la mise sur le marché de produits attractifs, abordables par tous. Ces produits ne sont plus seulement vendus par quelques boutiques mais par une myriade de vendeurs inexistants auparavant, donc créant de l’emploi. Même le commerce en ligne crée de l’emploi. Amazon s’était plantée à sa naissance. La raison : peu de stocks, peu d’entrepôts, un mauvais service. La firme a donc dû s’atteler à reprendre une vieille idée – l’entrepôt – pour recréer un service majeur qui occupe aujourd’hui des milliers d’emplois. La Poste ne gagne plus d’argent avec les timbres mais bien avec les petits colis de l’e-commerce. Il suffit de voir d’où vient DHL et que représente ce mastodonte aujourd’hui.

Des auteurs soulignent que l'automatisation peut aussi avoir un impact sur les incitations des entreprises à développer des technologies et des tâches de travail plus complexes qu'auparavant. Lorsque l'automatisation remplace les travailleurs et que les coûts de main-d'œuvre diminuent, les éventuelles nouvelles phases d'automatisation deviennent moins attrayantes du point de vue commercial. Du coup, les entreprises sont alors plus enclines à développer la formation de leurs employés et à conserver ainsi une main d’œuvre qui se qualifie davantage.

L’impact de la robotisation et de l'intelligence artificielle s’étend de toute manière sur une large liste de métiers. Les professions de qualification intermédiaire, comme les techniciens spécialisés, clerc de notaire, conducteur de train, d'avion, contremaître..., seraient potentiellement les plus attaqués. Tandis que certaines professions avec de plus faibles qualifications trouveraient paradoxalement leur maintien en raison de considérations culturelles : peu de gens envisagent des serveurs de restaurant, des vigiles, des moniteurs de sport, des artisans, des policiers ou des artistes du théâtre remplacés par des robots.

Actuellement, la ‘digitalisation’ du monde fait naître les mêmes questions que dans les années 1800 : y-a-t-il destruction de l’emploi ? Y-aura-t-il la fameuse ‘destruction créatrice’ chère à Schumpeter ? Les thèses s’affrontent durement, entre les optimistes et les déclinistes. En 2007, une étude signée par l'économiste Robert Atkinson soulignait qu'« il est improbable que le secteur du numérique crée un nombre proportionnel d'emplois avec sa taille. En partie parce que la productivité de ce secteur est telle qu'elle lui permet de produire beaucoup avec moins de travailleurs. » C’est bien connu : les progrès technologiques permettent d’effectuer plus de tâches par un seul homme qu’auparavant. Les locomotives à vapeur demandaient jadis deux hommes quand les locomotives électriques n’en demandent plus qu’un. Et les métros automatiques peuvent à présent s’en passer !

Mais comme par le passé, les innovations créées engendrent l’apparition d’autres innovations, d’autres emplois. Beaucoup d’innovations sont créées en combinant les idées anciennes avec les nouvelles. Les innovations permettent à leur tour de combiner de nouveaux types d'idées. Certaines des combinaisons réussissent à améliorer la productivité, d'autres pas. Le chômage technologique est une menace théorique depuis longtemps, mais pas mal d’études confirment qu’il ne s'est pas concrétisé au niveau de l'ensemble de l'économie : la quantité de travail n'a pas diminué sur le long terme, mais la nature des tâches exécutées a en revanche changé. En résumé, tout est affaire de compétences.

Le développement technologique crée en effet de nouveaux emplois plus productifs pour ceux qui sont capables d'exploiter de nouvelles machines. Au cours des dernières décennies, le développement technologique a en effet augmenté la demande de main-d'œuvre dans des tâches nécessitant un haut niveau d'éducation ainsi que des tâches complexes et de résolution de problèmes, en plus des tâches manuelles à faible salaire qui ne peuvent pas être transférées aux machines. Il n’est cependant pas dit que cela continuera à l’avenir de cette manière. Une certitude, la structure éducative de la population et l'offre de main-d'œuvre pour des emplois nécessitant un haut niveau d'expertise deviennent des facteurs clés et pourraient, à leur tour, créer davantage d’emplois dans l’enseignement et dans les formations en entreprises. Les entreprises traditionnelles seront dès lors priées d’offrir à leurs employés des formations continues, leur fournissant ainsi un capital humain supérieur à leurs concurrents.

Dans un autre registre, la baisse des prix des composants et l’addition de services sans cesse nouveaux permettent la mise sur le marché de produits attractifs, abordables par tous. Ces produits ne sont plus seulement vendus par quelques boutiques mais par une myriade de vendeurs inexistants auparavant, donc créant de l’emploi. Même le commerce en ligne crée de l’emploi. Amazon s’était plantée à sa naissance. La raison : peu de stocks, peu d’entrepôts, un mauvais service. La firme a donc dû s’atteler à reprendre une vieille idée – l’entrepôt – pour recréer un service majeur qui occupe aujourd’hui des milliers d’emplois. La Poste ne gagne plus d’argent avec les timbres mais bien avec les petits colis de l’e-commerce. Il suffit de voir d’où vient DHL et que représente ce mastodonte aujourd’hui.

Des auteurs soulignent que l'automatisation peut aussi avoir un impact sur les incitations des entreprises à développer des technologies et des tâches de travail plus complexes qu'auparavant. Lorsque l'automatisation remplace les travailleurs et que les coûts de main-d'œuvre diminuent, les éventuelles nouvelles phases d'automatisation deviennent moins attrayantes du point de vue commercial. Du coup, les entreprises sont alors plus enclines à développer la formation de leurs employés et à conserver ainsi une main d’œuvre qui se qualifie davantage.

L’impact de la robotisation et de l'intelligence artificielle s’étend de toute manière sur une large liste de métiers. Les professions de qualification intermédiaire, comme les techniciens spécialisés, clerc de notaire, conducteur de train, d'avion, contremaître..., seraient potentiellement les plus attaqués. Tandis que certaines professions avec de plus faibles qualifications trouveraient paradoxalement leur maintien en raison de considérations culturelles : peu de gens envisagent des serveurs de restaurant, des vigiles, des moniteurs de sport, des artisans, des policiers ou des artistes du théâtre remplacés par des robots.

xx

L’environnement social bouleversé

Dans le registre social, la destruction d’emploi n’est pas l’apanage de la seule digitalisation du monde. L’inventeur des valises à roulettes et des ‘cabin cases’ a provoqué la disparition des porteurs à bagages : cela n’avait rien de numérique. La machine à vapeur, l'électricité et les ordinateurs furent des inventions que la société a pu utiliser très largement dans différents secteurs de l'économie. Ils ont permis une réorganisation de la production et une accélération du taux de croissance de la productivité, au sens de la quantité de production réalisable par tête. C’est cela qui a fait que l’Europe se trouve au niveau où elle se situe de nos jours, comparé à d’autres continents qui n’ont pas connu de progrès technologiques, ou très peu.

Dans l'histoire de l’Humanité, l'introduction de nouvelles technologies à usage général s’est répandue comme une onde, même si une introduction à grande échelle de la technologie prend parfois du temps. La croissance de la productivité provient du fait que les usages utiles de cette technologie se répandent dans différents secteurs de l'économie. Ainsi la technique des distributeurs de billets de banque permet aussi de délivrer – moyennant adaptations techniques - des tickets de train ou de métro. Le QR Code permet aujourd’hui de tout vendre sur un seul petit écran, QR Code qui se répand partout dans le commerce en ligne, comme le fût le bon vieux code barre jadis. Mais que serait le smartphone sans la téléphonie mobile dont nous avons parlé plus haut ? Tout se tient, chaque nouveauté en répand une autre, et cela bouleverse les métiers et les certitudes. Et forcément cela fait peur...

Lorsque les avantages les plus importants des nouvelles technologies ont été exploités, la croissance de la productivité s’épuise. Du coup, quelque chose doit à nouveau être inventé pour relancer la machine. C’est bien connu : ce sont les innovations qui créent la demande et font croître le commerce. Le TGV a créé une demande de voyage qui n’existait pas avant lui. Le modèle économique de Ryanair a mis dans les avions une population fauchée qui ne voyageait pas, ou très peu, et ce en dépit de la critique sociale dont il fait l’objet. Le smartphone a créé des besoins qu’on ne connaissait pas dans les années 90, comme l’achat en ligne. Les besoins de l'humanité seraient infinis – en théorie, et jusqu’où ?- et, par conséquent, les produits et les services ne sont pas limités dans leur évolution et leur innovation. En conséquence, les technologies numériques peuvent être, selon certains auteurs, considérées comme un avantage car ils constituent une source importante de gains de productivité futurs.

Les plateformes digitales ont en revanche impulsé la fragmentation du marché du travail. En créant des opportunités inconnues jusqu’il y a peu, la révolution numérique a créé de nombreux nouveaux emplois, dans le style Uber ou Deliveroo, mais elle aura également introduit un phénomène de liquidité du marché du travail qui est contraire à l'obtention de droits sociaux, qui sont eux généralement acquis sur la durée et défendus avec hargne par ses bénéficiaires. Est-on encore salarié ou serions-nous à l’avenir tous indépendant ?

Dans un autre registre, plus humanisant, les technologies numériques ont le potentiel d'humaniser l'ergonomie du travail. D’une part les emplois de mauvaises conditions - un travail dangereux ou exigeant physiquement - peuvent être de plus en plus remplacés par de nouvelles technologies (le cas de certaines mines, par exemple). Les machines intelligentes et la robotique peuvent aussi aider les personnes ayant des restrictions physiques en leur permettant d'entrer dans un éventail plus large d'emplois. Les technologies numériques peuvent également contribuer à une gestion plus flexible du temps de travail des employeurs et des salariés. Le travail mobile, basé sur la technologie de la communication (TIC) peut permettre des dimensions totalement nouvelles en termes quantitatifs et qualitatifs, comme le télétravail.

La diffusion des technologies numériques peut différer en grande partie selon les catégories d’industries ou de régions, et la rapidité des changements potentiels n'est pas facile à évaluer. Le développement peut être aussi évolutif que perturbateur, car certaines technologies telles que la robotique pourraient ne pas être sensible en termes économiques et pourraient ne pas être acceptée selon les cultures nationales. On peut déjà observer des nations qui sont plus en avance que d’autres, par le simple fait de leur acceptation à aller de l’avant. Les anciennes régions industrielles et les industries « à l’ancienne » - tels les chemins de fer - peinent à se reconvertir du fait du scepticisme de leurs travailleurs et de la crainte du changement des habitudes. La vitesse de propagation du progrès technologique dépend aussi de la législation, elle-même dépendante du contexte social et politique d’une région donnée, ce qui accélère ou ralentit la vitesse de l'innovation. Différents types d'opportunités ou de risques peuvent survenir pour les parties concernées. Les entreprises peuvent exiger de nouvelles formes de flexibilité ainsi que de nouveaux types de compétences, pouvant créer des tensions sociales.

La difficulté d’appréhension du phénomène digital nous montre donc que le progrès technologique est à la fois une opportunité et une menace, tout dépend du contexte culturel. Une menace pour certains et une opportunité pour beaucoup. Les pays au Top10 qui misent le plus sur l'innovation sont pour la plupart européens, comprenant la Suisse, l’Allemagne et les pays scandinaves. On y trouve ailleurs Israël, Singapour et les États-Unis. Rappelons à ceux qui craignent les transformations que sur les 200 dernières années, le niveau de vie a été multiplié par dix en Occident. Il avait été multiplié par seulement quatre depuis J-C ! Et les continents du monde qui sont restés en marge du progrès connaissent les situations sociales les plus pires que l'on puisse trouver, entre guerres et famines récurrentes...

Dans l'histoire de l’Humanité, l'introduction de nouvelles technologies à usage général s’est répandue comme une onde, même si une introduction à grande échelle de la technologie prend parfois du temps. La croissance de la productivité provient du fait que les usages utiles de cette technologie se répandent dans différents secteurs de l'économie. Ainsi la technique des distributeurs de billets de banque permet aussi de délivrer – moyennant adaptations techniques - des tickets de train ou de métro. Le QR Code permet aujourd’hui de tout vendre sur un seul petit écran, QR Code qui se répand partout dans le commerce en ligne, comme le fût le bon vieux code barre jadis. Mais que serait le smartphone sans la téléphonie mobile dont nous avons parlé plus haut ? Tout se tient, chaque nouveauté en répand une autre, et cela bouleverse les métiers et les certitudes. Et forcément cela fait peur...

Lorsque les avantages les plus importants des nouvelles technologies ont été exploités, la croissance de la productivité s’épuise. Du coup, quelque chose doit à nouveau être inventé pour relancer la machine. C’est bien connu : ce sont les innovations qui créent la demande et font croître le commerce. Le TGV a créé une demande de voyage qui n’existait pas avant lui. Le modèle économique de Ryanair a mis dans les avions une population fauchée qui ne voyageait pas, ou très peu, et ce en dépit de la critique sociale dont il fait l’objet. Le smartphone a créé des besoins qu’on ne connaissait pas dans les années 90, comme l’achat en ligne. Les besoins de l'humanité seraient infinis – en théorie, et jusqu’où ?- et, par conséquent, les produits et les services ne sont pas limités dans leur évolution et leur innovation. En conséquence, les technologies numériques peuvent être, selon certains auteurs, considérées comme un avantage car ils constituent une source importante de gains de productivité futurs.

Les plateformes digitales ont en revanche impulsé la fragmentation du marché du travail. En créant des opportunités inconnues jusqu’il y a peu, la révolution numérique a créé de nombreux nouveaux emplois, dans le style Uber ou Deliveroo, mais elle aura également introduit un phénomène de liquidité du marché du travail qui est contraire à l'obtention de droits sociaux, qui sont eux généralement acquis sur la durée et défendus avec hargne par ses bénéficiaires. Est-on encore salarié ou serions-nous à l’avenir tous indépendant ?

Dans un autre registre, plus humanisant, les technologies numériques ont le potentiel d'humaniser l'ergonomie du travail. D’une part les emplois de mauvaises conditions - un travail dangereux ou exigeant physiquement - peuvent être de plus en plus remplacés par de nouvelles technologies (le cas de certaines mines, par exemple). Les machines intelligentes et la robotique peuvent aussi aider les personnes ayant des restrictions physiques en leur permettant d'entrer dans un éventail plus large d'emplois. Les technologies numériques peuvent également contribuer à une gestion plus flexible du temps de travail des employeurs et des salariés. Le travail mobile, basé sur la technologie de la communication (TIC) peut permettre des dimensions totalement nouvelles en termes quantitatifs et qualitatifs, comme le télétravail.

La diffusion des technologies numériques peut différer en grande partie selon les catégories d’industries ou de régions, et la rapidité des changements potentiels n'est pas facile à évaluer. Le développement peut être aussi évolutif que perturbateur, car certaines technologies telles que la robotique pourraient ne pas être sensible en termes économiques et pourraient ne pas être acceptée selon les cultures nationales. On peut déjà observer des nations qui sont plus en avance que d’autres, par le simple fait de leur acceptation à aller de l’avant. Les anciennes régions industrielles et les industries « à l’ancienne » - tels les chemins de fer - peinent à se reconvertir du fait du scepticisme de leurs travailleurs et de la crainte du changement des habitudes. La vitesse de propagation du progrès technologique dépend aussi de la législation, elle-même dépendante du contexte social et politique d’une région donnée, ce qui accélère ou ralentit la vitesse de l'innovation. Différents types d'opportunités ou de risques peuvent survenir pour les parties concernées. Les entreprises peuvent exiger de nouvelles formes de flexibilité ainsi que de nouveaux types de compétences, pouvant créer des tensions sociales.

La difficulté d’appréhension du phénomène digital nous montre donc que le progrès technologique est à la fois une opportunité et une menace, tout dépend du contexte culturel. Une menace pour certains et une opportunité pour beaucoup. Les pays au Top10 qui misent le plus sur l'innovation sont pour la plupart européens, comprenant la Suisse, l’Allemagne et les pays scandinaves. On y trouve ailleurs Israël, Singapour et les États-Unis. Rappelons à ceux qui craignent les transformations que sur les 200 dernières années, le niveau de vie a été multiplié par dix en Occident. Il avait été multiplié par seulement quatre depuis J-C ! Et les continents du monde qui sont restés en marge du progrès connaissent les situations sociales les plus pires que l'on puisse trouver, entre guerres et famines récurrentes...

Rechercher de la croissance : IBM

Le système IBM avait fait sa force dans un état donné de la technique et du marché. Mais quand technique et marché ont changé, les problèmes ont surgi. En 1993, IBM a affiché ce qui était la plus grande perte de l'histoire de l'Amérique industrielle, soit 8 milliards de dollars. Le CEO de l'époque a alors administré une reconversion radicale du mastodonte de 294.000 employés, qui a cessé la fabrication des composants pour se consacrer aux services informatiques (conseil en informatique, hébergement de serveurs intranet et extranet, gestion de la sécurité…). En 2006, ce segment représentaient un peu plus de la moitié de son chiffre d'affaires de 91,4 milliards de dollars. Mais les activités autour du mainframes déclinant, elle a de nouveau changé son organisation est recréant de nouvelles unités incluant R&D, ventes et livraisons, systèmes, Global Technology Services, cloud, Watson, sécurité, commerce, analytique.

Le système IBM avait fait sa force dans un état donné de la technique et du marché. Mais quand technique et marché ont changé, les problèmes ont surgi. En 1993, IBM a affiché ce qui était la plus grande perte de l'histoire de l'Amérique industrielle, soit 8 milliards de dollars. Le CEO de l'époque a alors administré une reconversion radicale du mastodonte de 294.000 employés, qui a cessé la fabrication des composants pour se consacrer aux services informatiques (conseil en informatique, hébergement de serveurs intranet et extranet, gestion de la sécurité…). En 2006, ce segment représentaient un peu plus de la moitié de son chiffre d'affaires de 91,4 milliards de dollars. Mais les activités autour du mainframes déclinant, elle a de nouveau changé son organisation est recréant de nouvelles unités incluant R&D, ventes et livraisons, systèmes, Global Technology Services, cloud, Watson, sécurité, commerce, analytique.

-WEc780af7f81.png)